Innovazione

Intelligenza artificiale: perché non parliamo d’altro e come farlo diversamente

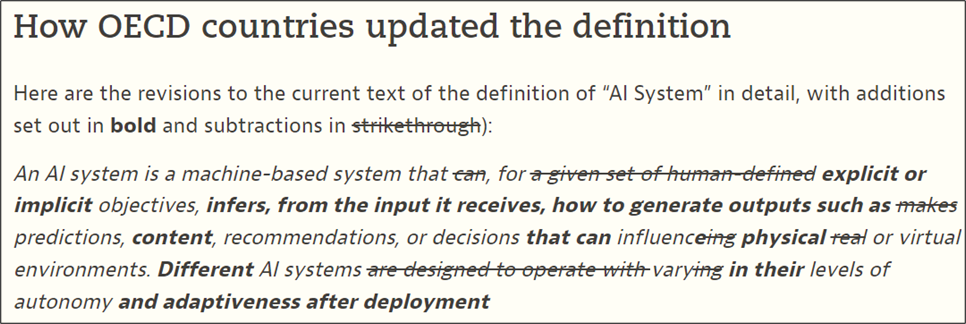

La definizione di intelligenza artificiale è tanto generosa e accogliente che in questo paradigma è possibile includere molte accezioni diverse, in cui è facile perdersi. Dando merito a chi ne ha parlato esplicitamente per primo, ovvero John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon durante una conferenza a Dartmouth College nel 1955, e in particolare in un documento di diciassette pagine che verrà ricordato come “la proposta di Dartmouth”, è possibile definire l’IA “la scienza e l’ingegneria della realizzazione di macchine intelligenti”. Un punto di inizio, e non certo d’arrivo, perché sarebbe necessario comprendere cosa si intenda per “macchine intelligenti” e, se poi fosse introdotto il concetto di “apprendimento”, avremmo necessità di definire quello di “Machine Learning”, ma poi anche quelli di “supervised learning”, “unsupervised learning”, “reinforcement learning” e “deep learning”. Da questi, si aprirebbero ancora altre strade. Per adesso, quindi, è sufficiente rendersi conto che stiamo guardando solo un frammento di un percorso, come fossimo ai bordi di una strada, che è iniziato da decenni ed è ancora agli albori, oltre che in costante movimento (FIGURA 1). Ma perché oggi non parliamo d’altro? La risposta è multifattoriale: big data, elevate capacità computazionali e algoritmi più performanti ne permettono un impiego diffuso, capace di incidere nella vita quotidiana di imprese e individui in maniera ancora più profonda rispetto alle innovazioni precedenti. Inoltre, e forse per questo, siamo in piena Hype[1].

FIGURA 1 – Evoluzione della definizione di intelligenza artificiale

Il pendolo dell’intelligenza artificiale oscilla oggi tra due estremi: da un lato, la risposta alla stagnazione della produttività e un aiuto determinante per la medicina e l’ambiente, dall’altro, un rischio per l’esistenza stessa dell’umanità. La discussione è polarizzata ed è difficile stabilire una posizione esatta e costante, per quanto i tentativi di regolamentazione o indirizzo – primo tra tutti quello dell’Unione europea, o la Bletchley Declaration on AI safety [2] – tentino di farla tendere verso l’estremo virtuoso, pur subendo le accuse di frenarne sul nascere lo sviluppo. Ciò che è certo è la sua capacità ipnotica: la costante osservazione di questa oscillazione ha ammaliato tutti, da chi si stupisce delle possibilità dell’IA generativa, scoprendola oggi, fino ai vertici economici e tecnologici, che ne osservano gli sviluppi da tempo e oggi ne promuovono le potenzialità, non sempre senza una dose di malizia.

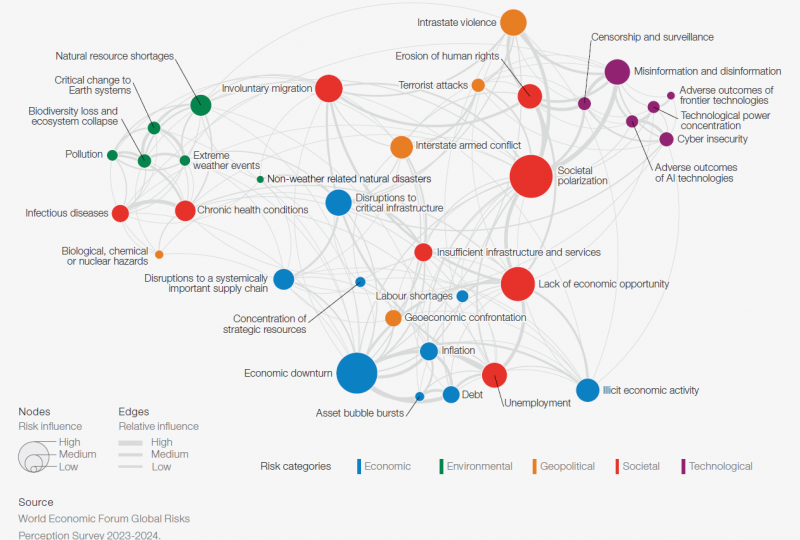

Per fare un esempio, l’intelligenza artificiale è ben presente del Global Risks Report 2024 del World Economic Forum: non solo nei rischi a breve termine – il primo rischio individuato a due anni è inerente alla disinformazione causata dalla tecnologia – ma anche a medio termine, dove gli “esiti negativi delle tecnologie di IA” si posizionano al sesto posto, dopo la già citata disinformazione. Allo stesso modo, proprio in questi giorni il Fondo Monetario internazionale ha pubblicato un report dal titolo “Gen-AI: Artificial Intelligence and the Future of Work”, nel quale si sottolinea come l’intelligenza artificiale abbia tanto il potenziale per aumentare significativamente la produttività e la crescita economica nelle economie avanzate, quanto quello di esacerbare le disuguaglianze di reddito e la delocalizzazione dei posti di lavoro, con un impatto che potrebbe interessare il 40% degli impieghi a livello mondiale e il 60% nelle economie avanzate.

Ed è questo un primo aspetto su cui è utile soffermarsi, esaminando uno dei grafici presenti nel lavoro del WEF e affiancandogli la riflessione del Professor Acemoglu, pubblicata su Wired poche settimane fa (Get Ready for the Great AI Disappointment): l’impatto che l’IA potrebbe avere sulla polarizzazione della ricchezza e il rischio che sia appannaggio di poche imprese – pare semplice guardare alle GAFAM, ovvero Google, Apple, Facebook, Amazon e Microsoft – , se non addirittura di costituire quasi un duopolio di fatto (Google – Microsoft, con la seconda in vantaggio). Nel grafo sottostante (FIGURA 2) i ricercatori hanno messo in relazione i diversi rischi, facendone emergere le interconnessioni e la loro intensità: la concentrazione nel potere tecnologico influenza gli esiti negativi dell’IA, così come, in misura minore, la mancanza di opportunità economiche o la disinformazione; questa, a sua volta, ha impatto sul rischio di sorveglianza e censura, sulla polarizzazione della società e sui potenziali conflitti. La polarizzazione sociale e la recessione economica sono visti come i rischi più interconnessi – e quindi influenti – nella rete globale dei rischi.

FIGURA 2 – Il panorama dei rischi globali: una mappa delle interconnessioni

Le tensioni nel Canale di Suez, oggi più gravi e preoccupanti dell’incagliamento della nave portacontainer Ever Given nel marzo 2021, così come la crescente importanza di Taiwan o la corsa in borsa di Nvidia, ci ricordano poi un aspetto spesso trascurato: non c’è software senza hardware, così come non c’è IA senza processori e infrastrutture capaci di farla agire. La fantascienza distopica in questo ci aiuta a capirlo: quando si vuole distruggere un’IA che ha preso il sopravvento, si va a colpire anche la sua parte fisica, meccanica.

Appare quindi chiaro perché lo storico Chris Miller abbia intitolato il suo libro, uscito nel 2022, “Chip War: The Fight for the World’s Most Critical Technology”[3], così come qui trovano il loro posto le iniziative statunitensi come il Creating Helpful Incentives for Producing Semiconductors (CHIPS and Science ACT; gennaio 2021) o il divieto all’export di semiconduttori verso la Cina (7 ottobre 2022) – che ha posto le basi per un decoupling in questo settore e ha ripercussioni anche sugli alleati americani – oppure l’European Chips Act. Gli USA provano a bloccare lo sviluppo cinese intervenendo lì dove possono, sull’hardware, consapevoli dello sterminato “cibo per IA” di cui dispone il Dragone, ovvero i dati di miliardi di persone, ma anche di una minore, per ora, capacità di progettare e realizzare chip ad alte prestazioni. Tale guerra commerciale riguarda, in modo cruciale, la leadership economica mondiale degli Stati Uniti, messa in discussione dall’accresciuta importanza della Cina, e tutte quelle tecnologie denominate dual use, ovvero con uso potenzialmente sia militare sia civile.

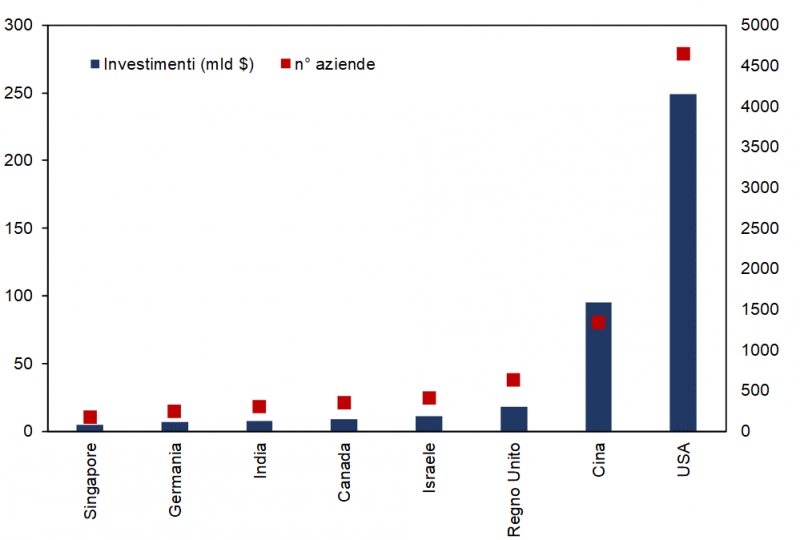

L’Europa segue, si adegua, tenta un’autonomia strategica aperta, spinge sull’effetto Bruxelles, regolamenta, ma resta indietro per investimenti, pubblici e privati, ed ecosistema, anche a causa della sua frammentazione (FIGURA 3).

FIGURA 3 – valore degli investimenti e nuove aziende nell’ambito dell’IA, primi 10 paesi

(somma anni dal 2013-2020, n° aziende sulla colonna di destra)

In sintesi, parlare di intelligenza artificiale richiede organizzazione e suddivisione degli argomenti: occorre considerarne la sua natura bifronte, hardware e software, a cui si aggiunge il capitale umano necessario a programmarla e utilizzarla; considerarne gli aspetti etici, regolatori e teorici; è necessario provare a circoscriverne il campo anche territorialmente, ad esempio all’Italia; comprenderne le implicazioni (reali o presunte) su produttività e lavoro e capire perché, come affermava l’economista Solow, «si vedono computer ovunque tranne che nelle statistiche della produttività»; ed esaminarne infine i potenziali effetti sulla quotidianità e sui diversi settori economici, cogliendo alcuni trend e novità interessanti.

L’analisi deve essere un prisma, in cui l’idea di IA entra e si divide poi in tanti aspetti, più (apparentemente) semplici da analizzare. Occorre un percorso per tappe: questa è solo la prima puntata.

———

[1] il modello dell’Hype cycle di Gartner ci ricorda come, solitamente, dopo una fase di grande entusiasmo segua una fase di disillusione, per poi – ridimensionate le aspettative – tornare su un sentiero più realistico.

[2] Nell’iconica Bletchley Park, l’1 e 2 novembre 2023 si è tenuto il primo summit globale sull’intelligenza artificiale, l’AI Safety Summit, che ha riunito l’UE e 28 paesi, inclusi USA e Cina, e un centinaio fra politici, accademici ed esponenti del settore tecnologico. Bletchley Park è una tenuta a circa 75 km a nord-ovest di Londra. Durante la Seconda guerra mondiale, fu la sede dell’unità principale di crittoanalisi del Regno Unito e della Government Code and Cypher School, che decifrò durante il conflitto migliaia di codici e messaggi, anche cifrati con la macchina Enigma e la cifratrice di Lorenz. La dichiarazione finale è il primo documento a livello mondiale firmato in materia di IA. L’Ue e i 28 Paesi riuniti nel vertice si sono soffermati, in particolare su: cooperazione Internazionale; politiche per lo sviluppo condiviso; risk management e standard di sicurezza; etica, trasparenza e responsabilità e l’auspicio che sia l’inizio di un percorso quanto più condiviso possibile.

[3] oltre al libro, consiglio anche l’approfondimento con l’autore organizzato dal MIT Security Studies Program a febbraio 2023.

Devi fare login per commentare

Accedi